一:安装Ollama

如果想要在本地运行 DeepSeek 需要用到 Ollama 这个工具,这是一个开源的本地大模型运行工具。

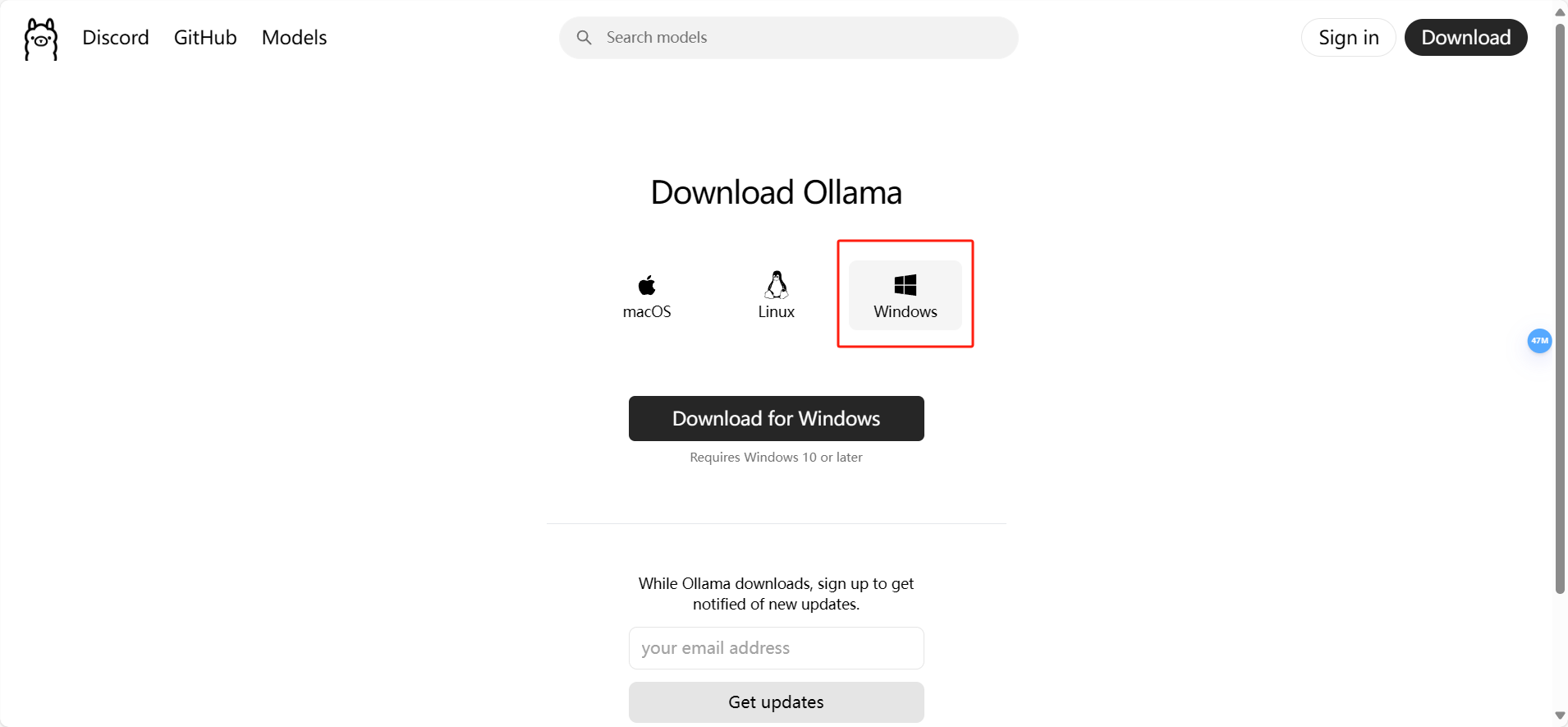

我们可以访问 https://ollama.com/ 进入 Ollama 官网下载 Ollama ,下载时有三个系统的安装包可选择,这里只需要选择下载我们电脑对应的操作系统版本即可,这里我选择的是 Windows 版本。

Ollama 安装包下载完成后直接双击安装即可,安装速度还是比较快的。

跟着提示安装就行

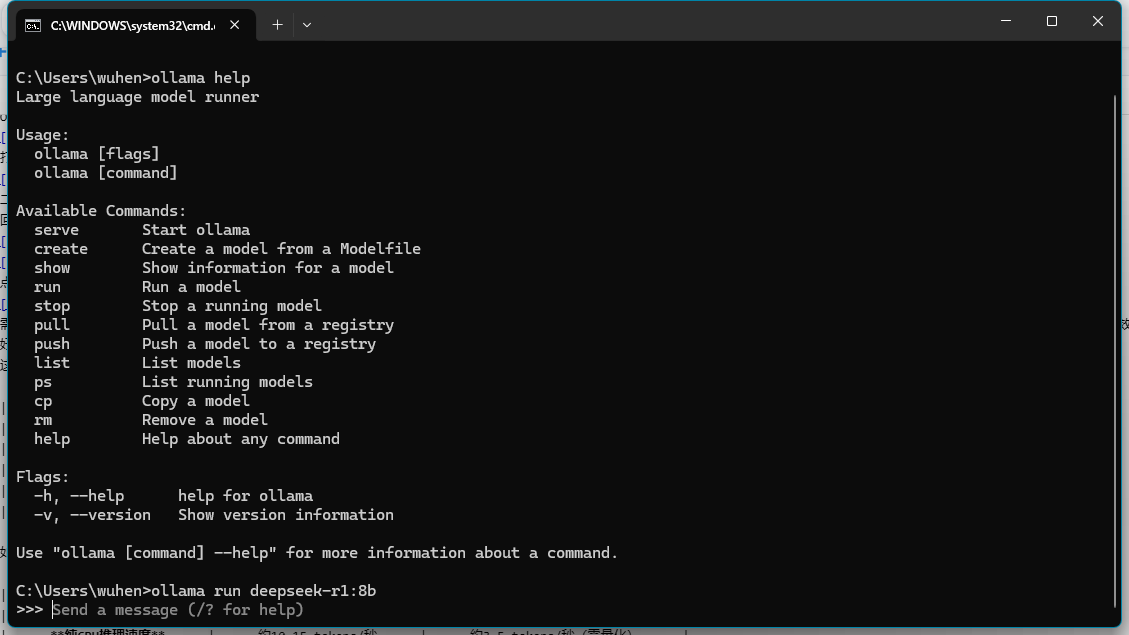

Ollama 安装完成后需要打开电脑的 CMD【win+r】 输入cmd,也就是命令提示符,只需要在电脑下方的搜索框中输入 cmd 即可打开。

打开后在命令提示符窗口中输入 ollama help 并按回车键,这个操作是为了验证这个软件是否安装成功,如果没有报错的话则表示这个软件安装成功。

二:下载部署 Deepseek 模型

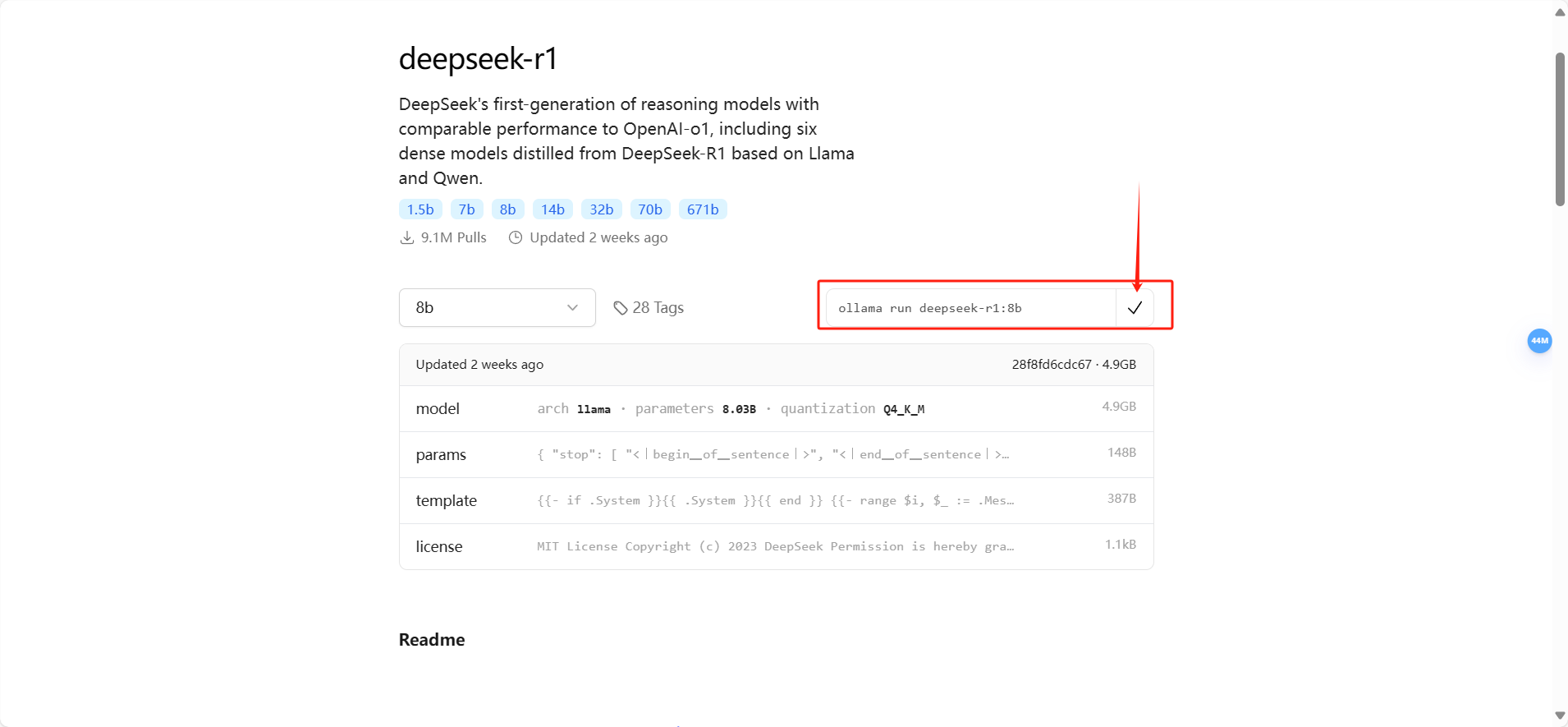

回到 https://ollama.com/ 网址中,在网页上方搜索框中输入 Deepseek-r1,这个 Deepseek-r1 就是我们需要本地部署的一个模型。

点击 Deepseek-r1 后会进入详情界面,里面有多个参数规模可供选择,从 1.5b 到 671b 都有,根据自己电脑性能选择,我电脑是4060用的8b。

需注意的是,这里我们需要根据自己电脑的硬件配置来选择模型大小,下面是一个模型大小配置参考表格,大家可根据自己的电脑配置来自行选择,当然了,部署的本地模型越大,使用的深度求索效果就越好。

这里可以参考一下deepseek的推荐,如果是本地的话,一般都是1.5b或者7b开始选择,都会有些纠结,哪个更适合自己,如下:

| 能力 | 1.5B 模型 | 7B 模型 |

|---|---|---|

| 微调数据需求 | 数据量少(百级样本) | 需要更多数据(千级样本) |

| 学习复杂模板能力 | 只能记住简单格式(如通知、函) | 可掌握复杂结构(如工作方案、红头文件) |

| 术语一致性 | 可能混淆相似术语(如“批复” vs “复函”) | 能精准区分专业词汇 |

| 资源消耗 | 微调仅需 6-8GB 显存 | 微调需 16-24GB 显存 |

如果只是一些集成显卡的,特别是笔记本,虽然号称有AI功能,但实际性能还是比较差的,可以参考一下:

| 场景 | 1.5B 模型 | 7B 模型 |

|---|---|---|

| 纯CPU推理速度 | 约10-15 tokens/秒 | 约3-5 tokens/秒(需量化) |

| GPU加速效果 | Arc显卡支持有限,提升不明显 | 同上,可能因显存带宽不足导致卡顿 |

| 内存占用(FP16) | ~3GB | ~14GB(需共享显存或内存) |

| 量化后内存占用(4-bit) | ~1GB | ~4GB |

| 公文写作质量 | 格式基本正确,但内容较简略 | 逻辑更严谨,可生成复杂方案/红头文件 |

选择好模型规模后,复制右边的一个命令。

命令复制完成后回到命令提示符窗口,将刚刚复制的命令粘贴到命令提示符窗口中并按回车键即可下载模型。

我这已经下载过了

模型下载完成后,我们就直接可以在命令提示符面板中使用它了。

以后如果我们需要再次使用 Deepseek 这个模型的话,我们可以直接打开命令提示符窗口,只需要再次在命令符提示窗口中输入上面复制的指令即可。

三:可视化图文交互界面

以下方式选择一种即可。

3.1 Chatbox

虽然我们可以在本地正常使用 Deepseek 这个模型了,但是这个 AI 工具的面板是非常简陋的,很多人使用不习惯,这时我们就可以通过 Chatbox 这个可视化图文交互界面来使用它。

点击 https://chatboxai.app/zh 进入 Chatbox 官网,Chatbox 虽然有本地客户端,但我们也可以直接使用网页版。

进入 Chatbox 网页版本后点击使用自己的 API Key 或本地模型。

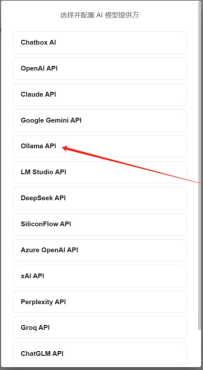

点击后会进入模型提供方选择界面,这里选择 Ollama API 。

这里需要注意的是,为了能够 Ollama 能远程链接,这里我们最好看一下 Chatbox 提供的教程,根据这个教程操作一下。

这个教程还是非常简单的,如果是 Windows 操作系统则只需要配置一下环境变量即可,配置完环境变量后需重启一下 Ollama 程序。

重启 Ollama 程序后,我们需要将 Chatbox 设置界面关闭并重新打开,重新打开 Chatbox 设置界面后即可选择 Deepseek 模型了,选择后 Deepseek 模型后点击保存即可。

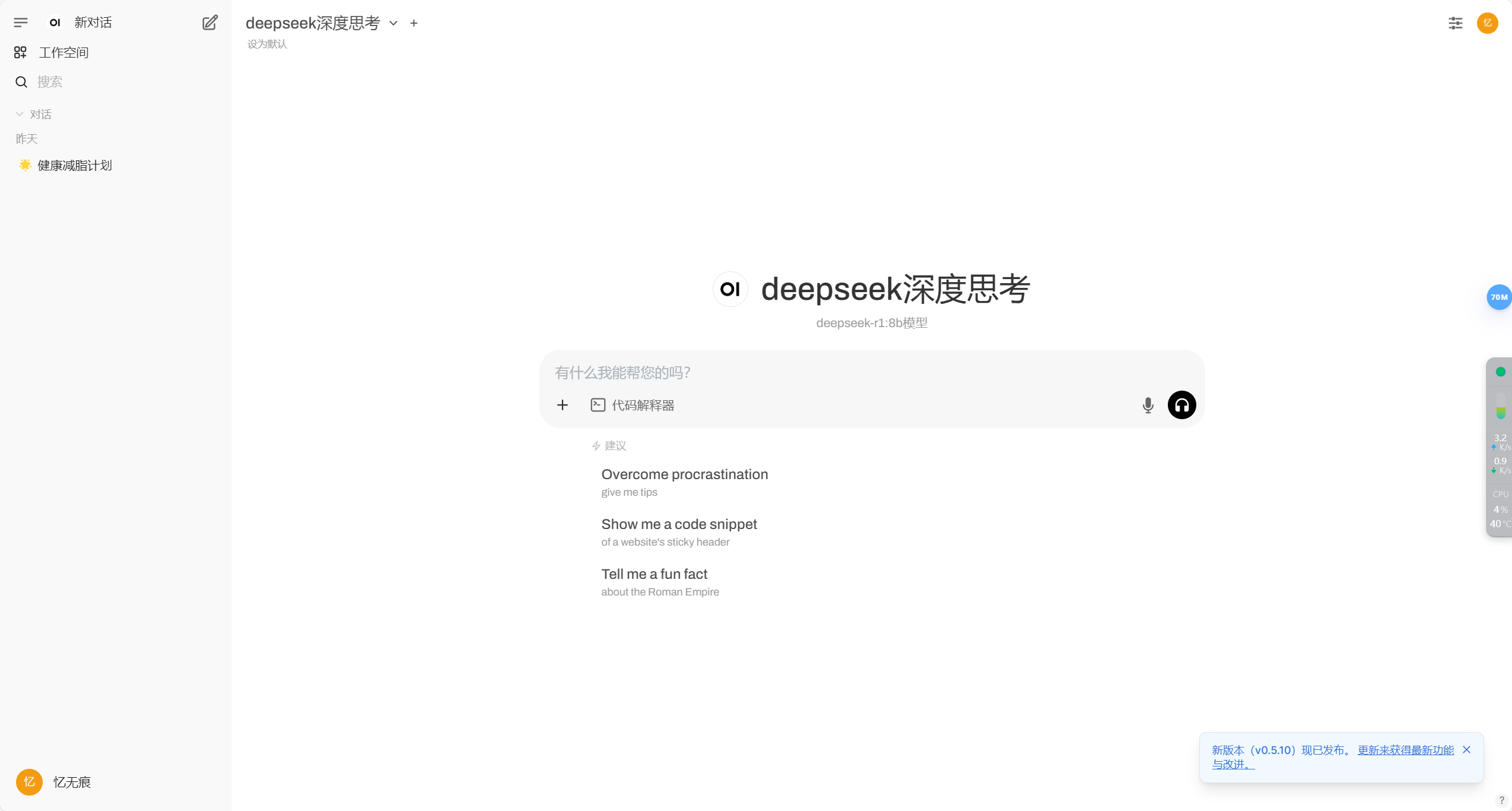

接下来只需要在 Chatbox 中新建对话即可使用 Deepseek 模型了,以下图为例,上方是它的思考过程,下方是它给出的答案。

3.2 OpenWebUI

OpenWebUI是一个可扩展、自托管的AI应用界面,允许用户自定义工作流程,并可在完全离线的状态下运行。它支持多种模型和工具,包括文本生成、图像生成和交互式工具。OpenWebUI旨在帮助开发者、研究者和企业快速部署和访问各种AI应用,特别是与生成式AI(如GPT、图像生成模型等)相关的应用。它还支持多种LLM运行器,包括Ollama和兼容OpenAI的API。此外,OpenWebUI是一个为多设备设计的自托管WebUI,支持离线使用,集成LMStudio、GroqCloud等API。

使用宝塔面包的docker应用一键部署安装,方便快速。

需要配置ollama的服务地址ip

部署完成页面-首页

使用页面

模型选择

评论一下吧

取消回复月白

发表于:2 个月前chrome-extension://jfgfiigpkhlkbnfnbobbkinehhfdhndo/options.html 这也有一个前端可视化工具